こんにちは。

あけましておめでとうございます。本年も当サイトをよろしくお願いいたします。

今回はGemini APIがついに無料で使えるようになったので、その紹介をしたいと思います。

LLMのAPI料金の概要

LLMの大手としてはOpenAI、Google、Anthropicが主流になってきたかと思います。

簡単に三社の現在(2025/8/24時点)の料金価格についてリンクを貼っておきます。

三社とも、これまでモデルの性能を改善しながら、コストダウン競争を続けております。

そしてやはりGeminiのみ、無料で使える枠があるのは大きな強みです。

以前は無料ではなかった2.0だけでなく、2.5以降の最新バージョンも無料で使えます。

OpenAIは発表当初こそ、期間限定で5ドルの無料枠がありましたが、現在はありません。

最近はOpenAIやAnthropicなどの人気におされているようにみえるGoogleですが、これは巻き返す可能性もありそうですね!

というわけでGemini APIの使い方について紹介します。

Gemini 2.5 Flash

以前は無料で使える代表として、Gemini 1.5 Flashを紹介していました。

今回は最新のGemini 2.5 Flashについてご紹介します。

入力としてテキスト以外にも画像や動画、音声といったマルチモーダル対応モデルになります。

入出力のトークン上限もかなり大きくなっているため、長文や長い音声データなどにも対応できます。

画像生成と音声生成が対応できないようです。

続いて料金をみていきます。

今までは1分間に15回のリクエストで制限がかかるなどの仕様でしたが、そういった制限はなくなったようです。

有料枠との差分としては、

- コンテキストキャッシュ(会話履歴)の保存機能の有無

- Google検索によるグラウンディング(引用などを用いてハルシネーションを軽減する機能)の上限差

- 学習データ利用(プライバシーモード)の有無

無料枠でインプットしたデータはGoogleの学習に利用されるというのが、無料枠での引き続きのデメリットになります。

以前の制約条件に比べれば、ほぼ有料枠と変わらないレベルでAPIを使えるようになったのはうれしいですね!

APIキーの取得方法

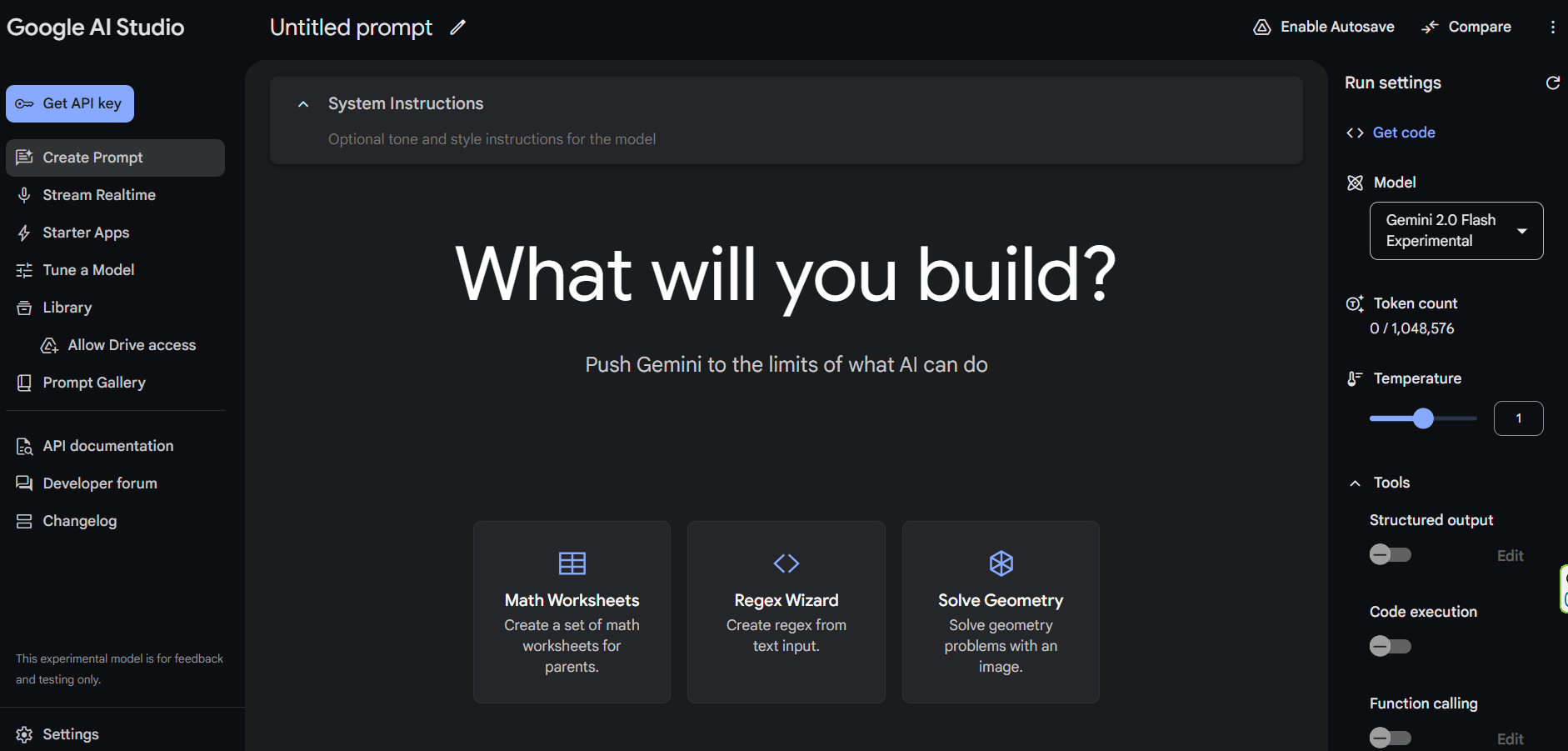

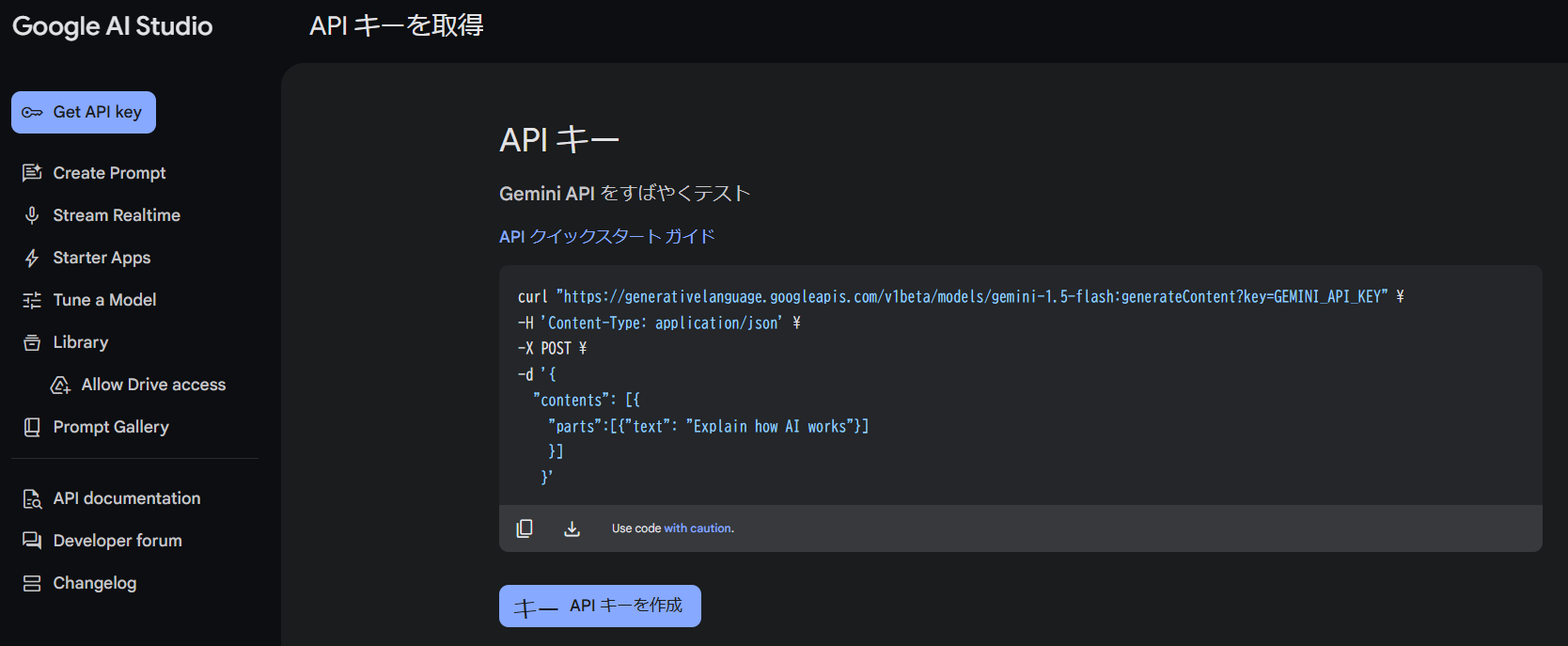

では先ほどのGemini 2.5 Flash内の「Google AI Studioで試す」をクリックします。

Googleアカウントでログインすると、以下のようなWebアプリが開くかと思います。

こちらでもGeminiを色々試せますので、興味があれば触ってみてください。

今回は左上の「Get API Key」をクリックします。

真ん中の「APIキーを作成」をクリックします。

そうするとGoogle Cloudプロジェクトが自動で作成されるか、既存のものがあればそこから選択します。

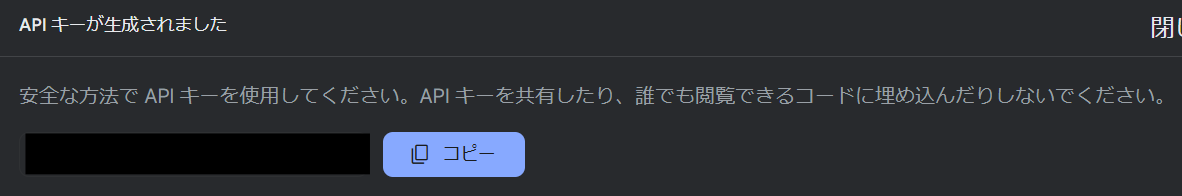

APIキーが作成されましたら、コピーしておきます。

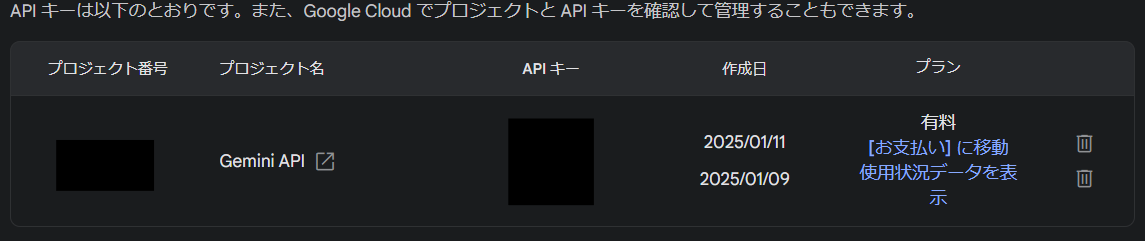

画面戻ると以下のようになっていればOKです。

プランが「有料」になっていますが、気にしなくて大丈夫です。そのうち無料に表示も変わります。

お支払い方法も設定しなくてOKです。

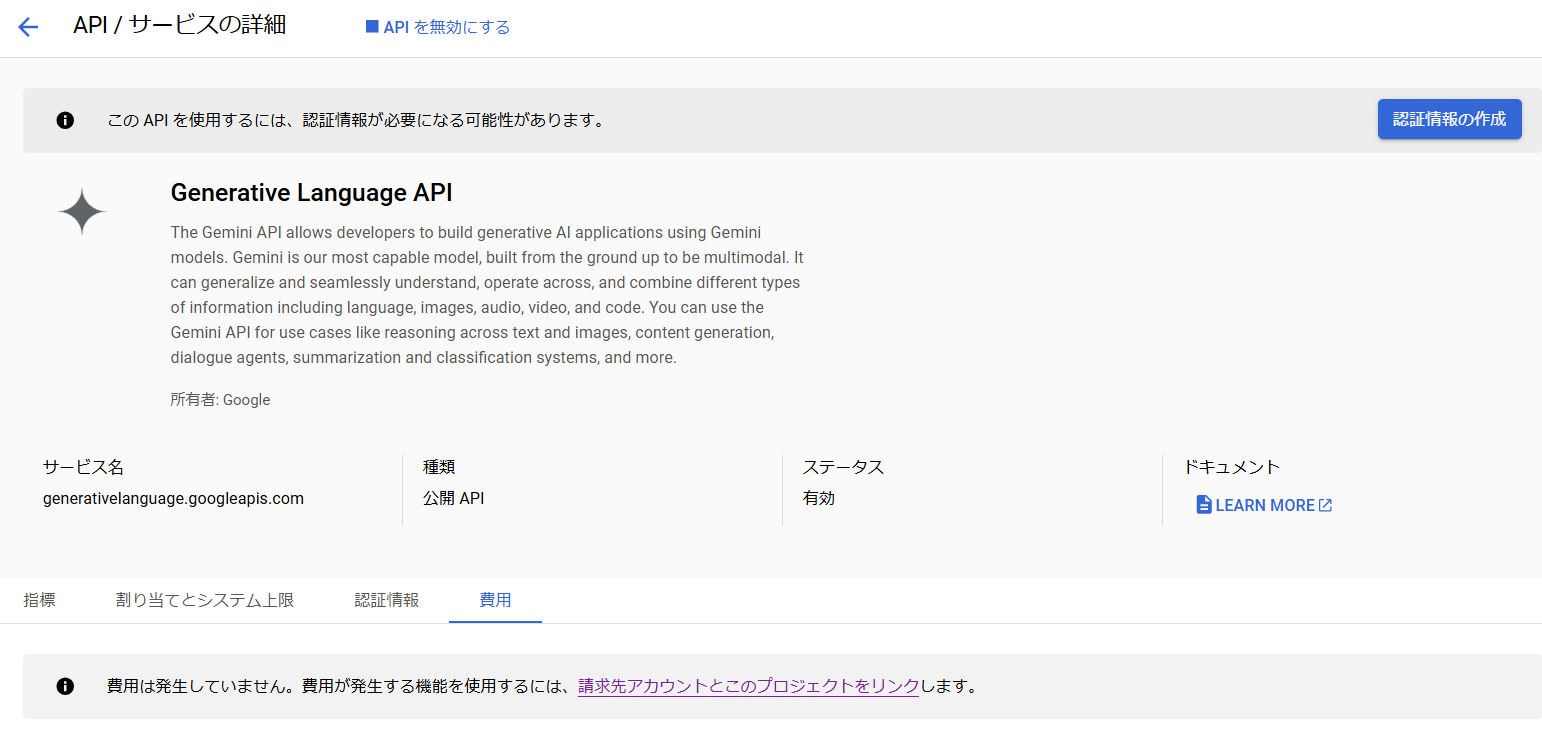

ちなみに使用状況データを表示をクリックすれば、以下のように確認できます。

何回か動かしてますが、費用も発生しておりません。

これでAPIキーの準備は完了です。

では早速動かしてみましょう。

Gemini APIを動かす

ではGoogle Gemini APIの公式ドキュメントにアクセスします。

クイックスタートの通りに動かしてみます。

まずはお使いのPython3.9以降の仮想環境やDocker等に、以下のコマンドでインストールしましょう。

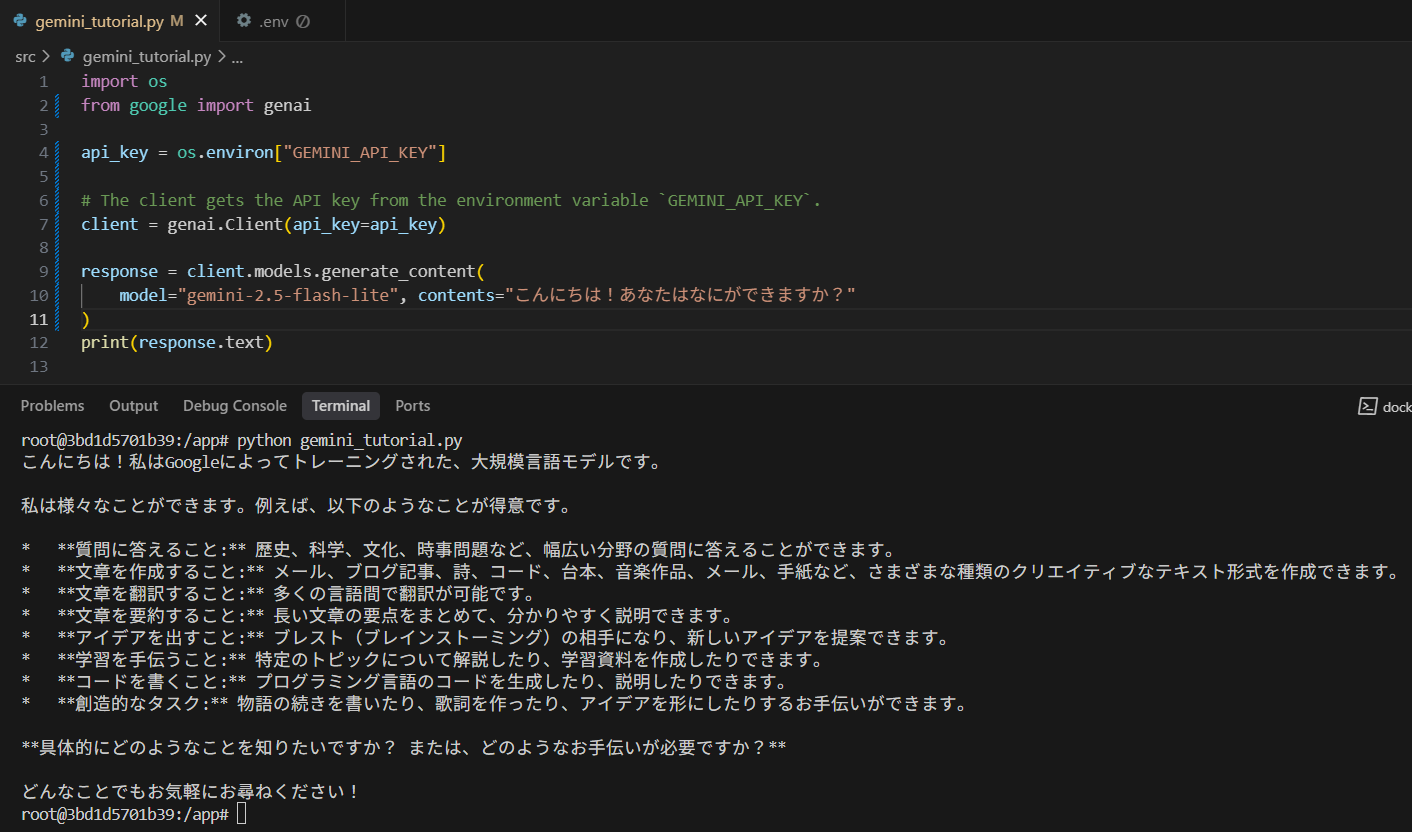

pip install google-genaiでは以下のコードに、先ほど取得したAPIキーを追加しましょう。

modelをgemini-2.5-flash-liteを使用しています。

gemini-2.5-flashの低コストバージョンなので、お試し用モデルとしておすすめです。

from google import genai

# The client gets the API key from the environment variable `GEMINI_API_KEY`.

client = genai.Client(api_key=api_key)

response = client.models.generate_content(

model="gemini-2.5-flash-lite", contents="こんにちは!あなたはなにができますか?"

)

print(response.text)ちなみに私のおすすめはコード内にAPIキー打ち込むのではなく、.envファイルを作成して別ファイルで見えないように管理する方法がおすすめです。

.envファイルを作成して「GEMINI_API_KEY = “your api key”」 としてください。

実際のコードについては以下の私のコードをご参考ください。

日本語でもうまく返してくれますね。

LangChainで動かす

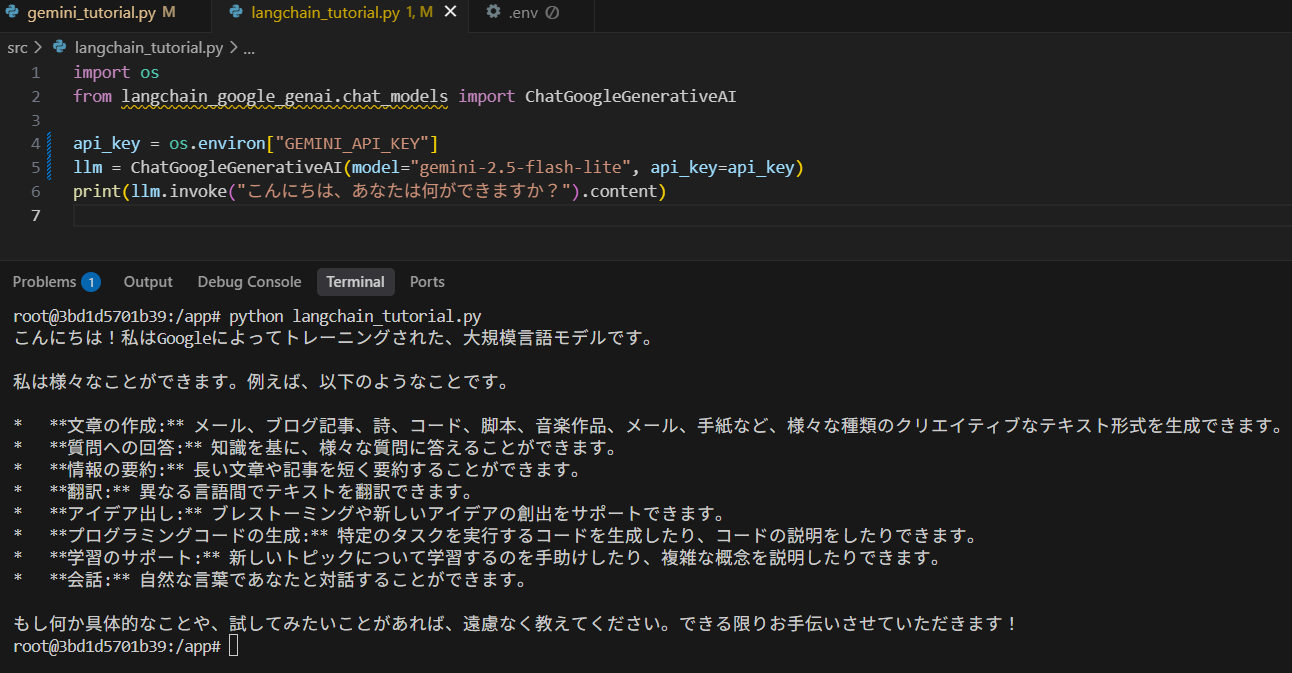

APIキーが使えるならば、LangChainなどの他のフレームワークでも使えそうですよね。

以下のコマンドでライブラリを追加しましょう。

pip install langchain-google-genaiこちらも同じようなコードにしてみたいと思います。

import os

from langchain_google_genai.chat_models import ChatGoogleGenerativeAI

api_key = os.environ["GOOGLE_API_KEY"]

llm = ChatGoogleGenerativeAI(model="gemini-2.5-flash-lite", api_key=api_key)

print(llm.invoke("こんにちは、あなたは何ができますか?").content)先ほどのコードと似たような回答が得られました。

このように、LangChainの中でも使えますし、GoogleGenAIでもAPIを使うことができます。

書き方もほぼ似たようなものなので、あとは書き方の好みやライブラリの使い勝手次第でお好きな方を使い分ければ良いかと思います。

まとめ

以上のように、Gemini 2.5 Flashは無料で使えてLangChainなどのフレームワーク内でも使用することができます。

とりあえずLLMを使ってコード書いたらどうなるかな?

まずシステムとしてうまく動くかな?

このように試行錯誤したい需要には、大手LLMのAPIの中では、Geminiが最適解となっているように感じております。

コストを気にせず、穏やかに研究・開発することが大事かと思いますので、良かったらGemini APIを使ってみてはいかがでしょうか?

ここまでご覧いただきありがとうございました!